资源简介

爬取商品详情。

代码片段和文件信息

import org.apache.commons.lang3.StringUtils;

import net.sf.json.JSONobject;

import org.jsoup.Jsoup;

import org.jsoup.nodes.Document;

import org.jsoup.nodes.Element;

import org.jsoup.select.Elements;

import java.io.IOException;

import java.net.URLEncoder;

import java.util.*;

import java.util.regex.Matcher;

import java.util.regex.Pattern;

/**

* Created with Chenquan.

* Description: 淘宝抓包

* Date: 2018-12-13

* Time: 15:12

*/

public class test {

public static void main(String[] args) {

int i = 0;

//填写商品详情网站

String substring = getParamByUrl(“https://detail.tmall.com/item.htm?spm=a1z10.10550-b.193.11.43c44d028KCTcr&id=580863947060““id“);

getAll(substring);

}

public static void getAll(String item_id ) {

try {

Thread.sleep(2000);//一个休息5s,太快会被禁

} catch (InterruptedException e) {

e.printStackTrace();

}

System.out.println(“开始时间:“ + new Date());

Date dateStart = new Date();

Document doc = null;

String id = ““;

try {

String url = “https://item.taobao.com/item.htm?id=“+item_id;

id = getParamByUrl(url “id“);

doc = Jsoup.connect(url).ignoreContentType(true).get();

} catch (IOException e) {

e.printStackTrace();

}

if (doc.baseUri().contains(“tmall“)) {

System.out.println(“商品名称:“+ doc.select(“h1[data-spm=\“1000983\“]“).text());

}else {

System.out.println(“商品名称:“ + doc.select(“h3[class=\“tb-main-title\“]“).text());

}

Elements imgSrcElement = doc.select(“#J_UlThumb > li“);

for (Element element : imgSrcElement) {

String imgSrc = ““;

if (element.baseUri().contains(“tmall“)){

imgSrc = element.getElementsByTag(“img“).attr(“src“);

}else{

imgSrc = element.getElementsByTag(“img“).attr(“data-src“);

}

// imgSrc = imgSrc.replaceFirst(“//img.alicdn.com/imgextra/“ ““);

//imgSrc = imgSrc.substring(0 imgSrc.length() - 10);

imgSrc = imgSrc.replaceAll(“_60x60q90.jpg“““); //处理掉不必要的数据

//String substring = imgSrc.substring(imgSrc.indexOf(“_60“) + 3 imgSrc.lastIndexOf(“.jpg“));

//String substring = imgSrc.substring(0 imgSrc.lastIndexOf(“.jpg“));

//String substring = imgSrc.substring(0 imgSrc.lastIndexOf(“jpg_“));

System.out.println(“主图url:“ + imgSrc);

}

// 规格参数

Elements selectRules = doc.select(“.J_TSaleProp“);

List> liHashMap = new ArrayList<>();

for (Element ulElement : selectRules) {

String ul = ulElement.getElementsByTag(“ul“).attr(“data-property“);

System.out.println(“ul:“ + ul);

List liString = new ArrayList<>();

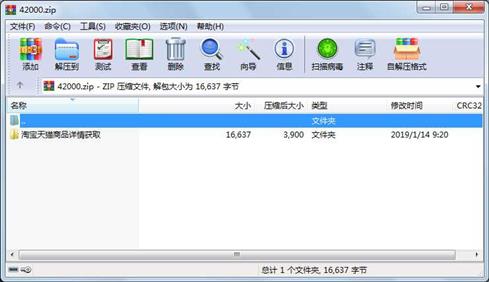

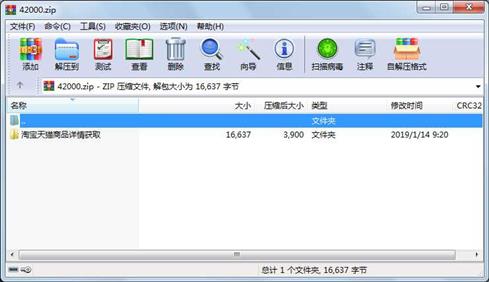

for (Element liElement : ulElement.getElem 属性 大小 日期 时间 名称

----------- --------- ---------- ----- ----

文件 14383 2019-01-14 09:19 淘宝天猫商品详情获取\test.java

文件 2254 2019-01-11 14:48 淘宝天猫商品详情获取\test1.java

目录 0 2019-01-14 09:20 淘宝天猫商品详情获取\

相关资源

- 很好用的网站前端页面爬取工具

- 爬取豆瓣电影TOP250程序,包含非常详

- 爬取豆瓣排行榜电影数据(含GUI界面

- 爬取新浪微博上的妹纸照片的爬虫程

- 文本爬取和分词预处理.pdf

- 微博图片爬取工具

- 58同城招聘信息爬取

- 豆瓣爬取图书数据

- 自动爬取百度谷歌图片

- 2020年5月份全国地铁站地理坐标高德地

- 网易云评论爬取-代码

- RCurl爬取天猫评论

- 某招聘网爬取数据分析岗位数据.xls

- Delphi网页爬取.rar

- 知乎爬虫代码

- 爬取微信公众号中的历史消息点赞量

- scrapy简单的多层页面爬取程序

- 用PyQT5多线程爬取轻小说工具

- 全国学校shp文件

- poi数据爬取工具

- lianjia.zip

- 爬取学堂在线合作院校页面内容学堂

- 百度地图矢量工具

- 爬取微博的所有转发链接使用说明文

- 汽车之家爬取数据集超过30000条数据

- scrapy ---爬取豌豆荚并分析数据

- 爬取一个用户的所有微博

- 网络爬虫爬取网页链接

- 房天下网站爬取的武汉市小区数据

- 仿站小工具9.0正式版.rar

川公网安备 51152502000135号

川公网安备 51152502000135号

评论

共有 条评论