资源简介

包括Python分词,去停用词,使用gensim包进行LDA主题分析,并输出每条矩阵属于每个主题的概率的代码,以及停用词表

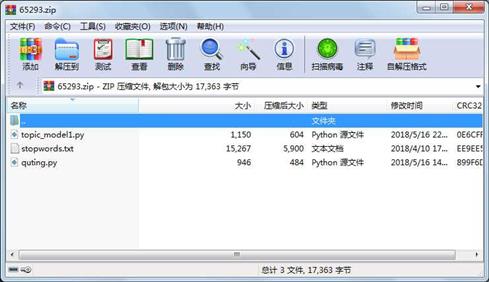

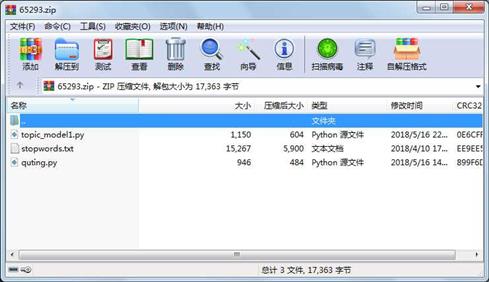

代码片段和文件信息

import jieba

# jieba.load_userdict(‘userdict.txt‘)

# 创建停用词list

def stopwordslist(filepath):

stopwords = [line.strip() for line in open(filepath ‘r‘ encoding=‘utf-8‘).readlines()]

return stopwords

# 对句子进行分词

def seg_sentence(sentence):

sentence_seged = jieba.cut(sentence.strip())

stopwords = stopwordslist(‘D:/LDA/stopwords.txt‘) # 这里加载停用词的路径

outstr = ‘‘

for word in sentence_seged:

if word not in stopwords:

if word != ‘\t‘:

outstr += word

outstr += “ “

return outstr

#读入需要分词的文件

inputs = open(‘D:/LDA/dp.txt‘ ‘r‘ encoding=‘utf-8‘)

#输出分词结果

outputs = open(‘D:/LDA/dp_fenci.txt‘ ‘w‘encoding=‘utf-8‘)

for line in inputs:

line_seg = seg_sentence(line) # 这里的返回值是字符串

outputs.write(line_seg + ‘\n‘)

outputs.close()

inputs.close()属性 大小 日期 时间 名称

----------- --------- ---------- ----- ----

文件 15267 2018-04-10 17:44 stopwords.txt

文件 1150 2018-05-16 22:04 topic_model1.py

文件 946 2018-05-16 14:45 quting.py

- 上一篇:DNN判断句子的通顺程度.py

- 下一篇:基于python的网络爬虫设计

川公网安备 51152502000135号

川公网安备 51152502000135号

评论

共有 条评论