资源简介

相关向量机的MATLAB代码,经过验证是正确的,很实用

推荐相关向量机(Relevance vector machine,简称RVM)是Tipping在2001年在贝叶斯框架的基础上提出的,它有着与支持向量机(Support vector machine,简称SVM)一样的函数形式,与SVM一样基于核函数映射将低维空间非线性问题转化为高维空间的线性问题。

RVM原理步骤

RVM通过最大化后验概率(MAP)求解相关向量的权重。对于给定的训练样本集{tn,xn},类似于SVM , RVM 的模型输出定义为

y(x;w)=∑Ni=1wiK(X,Xi)+w0

其 中wi为权重, K(X,Xi)为核函。因此对于, tn=y(xn,w)+εn,假设噪声εn 服从均值为0 , 方差为σ2 的高斯分布,则p ( tn | ω,σ2 ) = N ( y ( xi ,ωi ) ,σ2 ) ,设tn 独立同分布,则整个训练样本的似然函数可以表示出来。对w 与σ2的求解如果直接使用最大似然法,结果通常使w 中的元素大部分都不是0,从而导致过学习。在RVM 中我们想要避免这个现像,因此我们为w 加上先决条件:它们的机率分布是落在0 周围的正态分布: p(wi|αi) = N(wi|0, α?1i ),于是对w的求解转化为对α的求解,当α趋于无穷大的时候,w趋于0.

RVM的步骤可以归结为下面几步:

1. 选择适当的核函数,将特征向量映射到高维空间。虽然理论上讲RVM可以使用任意的核函数,但是在很多应用问题中,大部分人还是选择了常用的几种核函 数,RBF核函数,Laplace核函数,多项式核函数等。尤其以高斯核函数应用最为广泛。可能于高斯和核函数的非线性有关。选择高斯核函数最重要的是带 宽参数的选择,带宽过小,则导致过学习,带宽过大,又导致过平滑,都会引起分类或回归能力的下降

2. 初始化α,σ2。在RVM中α,σ2是通过迭代求解的,所以需要初始化。初始化对结果影响不大。

3. 迭代求解最优的权重分布。

4. 预测新数据。

代码片段和文件信息

function [MERMSEABSEr] = ComputeResults(DesPred)

ME = mean(Des-Pred);

RMSE = sqrt(mean((Des-Pred).^2));

ABSE = mean(abs(Des-Pred));

rr = corrcoef(DesPred); r = rr(12);

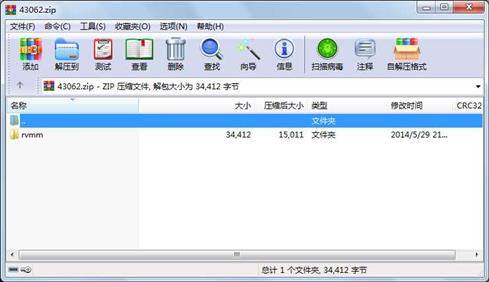

属性 大小 日期 时间 名称

----------- --------- ---------- ----- ----

目录 0 2014-05-29 21:45 rvmm\

目录 0 2014-05-29 21:45 rvmm\code_rvm\

文件 1908 2014-05-27 18:40 rvmm\code_rvm\demo_rvm.m

文件 65 2002-09-04 17:16 rvmm\code_rvm\getEnvironment.m

文件 4150 2002-09-04 17:21 rvmm\code_rvm\License.txt

文件 4924 2005-08-03 14:47 rvmm\code_rvm\sbl_estimate.m

文件 2801 2002-10-03 14:05 rvmm\code_rvm\sbl_example_c.m

文件 1967 2004-10-17 16:01 rvmm\code_rvm\sbl_example_r.m

文件 2572 2005-08-03 19:42 rvmm\code_rvm\sbl_kernelFunction.m

文件 2261 2002-09-04 17:16 rvmm\code_rvm\sbl_postMode.m

文件 2026 2002-09-04 17:17 rvmm\code_rvm\sbl_rvm.m

文件 226 2002-09-04 17:17 rvmm\code_rvm\setEnvironment.m

文件 187 2005-02-04 16:06 rvmm\ComputeResults.m

文件 2419 2005-10-11 15:14 rvmm\demo_rvm.m

文件 2755 2005-09-26 10:19 rvmm\demo_rvm2.m

文件 317 2005-08-03 16:52 rvmm\ErrorStruct.m

文件 528 2005-08-04 07:13 rvmm\InitStruct.m

文件 1879 2005-09-17 13:11 rvmm\PlotResults.m

文件 225 2005-08-03 12:26 rvmm\scalestd.m

文件 3202 2005-08-04 07:13 rvmm\TrainRVM.m

川公网安备 51152502000135号

川公网安备 51152502000135号

评论

共有 条评论