资源简介

开发爬虫中,始终受困于爬虫的效率问题,后多方查看资料,根据已掌握的信息编写了该项目,此demo完全基于python的协程思想实现,不管是自己研究用还是应用到自己的项目中都可以。需要的小伙伴快下载来使用吧

代码片段和文件信息

from bs4 import BeautifulSoup

import requests

from urllib.parse import urlparse

start_url = ‘https://www.cnblogs.com‘

trust_host = ‘www.cnblogs.com‘

ignore_path = []

history_urls = []

def parse_html(html):

soup = BeautifulSoup(html “lxml“)

print(soup.title)

links = soup.find_all(‘a‘ href=True)

return (a[‘href‘] for a in links if a[‘href‘])

def parse_url(url):

url = url.strip()

if url.find(‘#‘) >= 0:

url = url.split(‘#‘)[0]

if not url:

return None

if url.find(‘javascript:‘) >= 0:

return None

for f in ignore_path:

if f in url:

return None

if url.find(‘http‘) < 0:

url = start_url + url

return url

parse = urlparse(url)

if parse.hostname == trust_host:

return url

def consumer():

html = ‘‘

while True:

url = yield html

if url:

print(‘[CONSUMER] Consuming %s...‘ % url)

rsp = requests.get(url)

html = rsp.content

def produce(c):

next(c)

def do_work(urls):

for u in urls:

if u not in history_urls:

history_urls.append(u)

print(‘[PRODUCER] Producing %s...‘ % u)

html = c.send(u)

results = parse_html(html)

work_urls = (x for x in map(parse_url results) if x)

do_work(work_urls)

do_work([start_url])

c.close()

if __name__ == ‘__main__‘:

c = consumer()

produce(c)

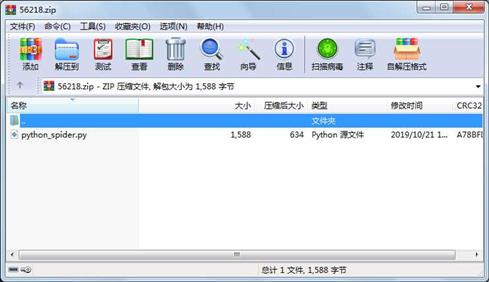

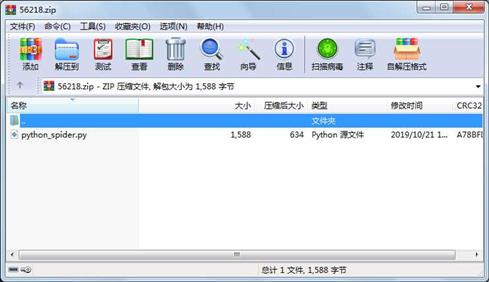

print(len(history_urls)) 属性 大小 日期 时间 名称

----------- --------- ---------- ----- ----

文件 1588 2019-10-21 14:10 python_spider.py

相关资源

- python+ selenium教程

- PycURL(Windows7/Win32)Python2.7安装包 P

- 英文原版-Scientific Computing with Python

- 7.图像风格迁移 基于深度学习 pyt

- 基于Python的学生管理系统

- A Byte of Python(简明Python教程)(第

- Python实例174946

- Python 人脸识别

- Python 人事管理系统

- 基于python-flask的个人博客系统

- 计算机视觉应用开发流程

- python 调用sftp断点续传文件

- python socket游戏

- 基于Python爬虫爬取天气预报信息

- python函数编程和讲解

- Python开发的个人博客

- 基于python的三层神经网络模型搭建

- python实现自动操作windows应用

- python人脸识别(opencv)

- python 绘图(方形、线条、圆形)

- python疫情卡UN管控

- python 连连看小游戏源码

- 基于PyQt5的视频播放器设计

- 一个简单的python爬虫

- csv文件行列转换python实现代码

- Python操作Mysql教程手册

- Python Machine Learning Case Studies

- python获取硬件信息

- 量化交易(附python常见函数的使用方

- python 名字用字排行

川公网安备 51152502000135号

川公网安备 51152502000135号

评论

共有 条评论