资源简介

基于MATLAB的KAPPA系数计算。The confusion matrix was used to describe the classification accuracy and to characterize the errors. Landis and Koch (1977) classified Kappa values into different categories: 0-0.20, 0.21-0.40, 0.41-0.60, 0.61-0.80 and 0.81-1, which indicates slight, fair, moderate, substantial and almost perfect agreements, respectively.

代码片段和文件信息

function kappa(varargin)

% KAPPA: This function computes the Cohen‘s kappa coefficient.

% Cohen‘s kappa coefficient is a statistical measure of inter-rater

% reliability. It is generally thought to be a more robust measure than

% simple percent agreement calculation since k takes into account the

% agreement occurring by chance.

% Kappa provides a measure of the degree to which two judges A and B

% concur in their respective sortings of N items into k mutually exclusive

% categories. A ‘judge‘ in this context can be an individual human being a

% set of individuals who sort the N items collectively or some non-human

% agency such as a computer program or diagnostic test that performs a

% sorting on the basis of specified criteria.

% The original and simplest version of kappa is the unweighted kappa

% coefficient introduced by J. Cohen in 1960. When the categories are

% merely nominal Cohen‘s simple unweighted coefficient is the only form of

% kappa that can meaningfully be used. If the categories are ordinal and if

% it is the case that category 2 represents more of something than category

% 1 that category 3 represents more of that same something than category

% 2 and so on then it is potentially meaningful to take this into

% account weighting each cell of the matrix in accordance with how near it

% is to the cell in that row that includes the absolutely concordant items.

% This function can compute a linear weights or a quadratic weights.

%

% Syntax: kappa(XWALPHA)

%

% Inputs:

% X - square data matrix

% W - Weight (0 = unweighted; 1 = linear weighted; 2 = quadratic

% weighted; -1 = display all. Default=0)

% ALPHA - default=0.05.

%

% Outputs:

% - Observed agreement percentage

% - Random agreement percentage

% - Agreement percentage due to true concordance

% - Residual not random agreement percentage

% - Cohen‘s kappa

% - kappa error

% - kappa confidence interval

% - Maximum possible kappa

% - k observed as proportion of maximum possible

% - k benchmarks by Landis and Koch

% - z test results

%

% Example:

%

% x=[88 14 18; 10 40 10; 2 6 12];

%

% Calling on Matlab the function: kappa(x)

%

% Answer is:

%

% UNWEIGHTED COHEN‘S KAPPA

% --------------------------------------------------------------------------------

% Observed agreement (po) = 0.7000

% Random agreement (pe) = 0.4100

% Agreement due to true concordance (po-pe) = 0.2900

% Residual not random agreement (1-pe) = 0.5900

% Cohen‘s kappa = 0.4915

% kappa error = 0.0549

% kappa C.I. (alpha = 0.0500) = 0.3839 0.5992

% Maximum possible kappa given the observed marginal frequencies = 0.8305

% k observed as proportion of maximum possible = 0.5918

% Moderate agreement

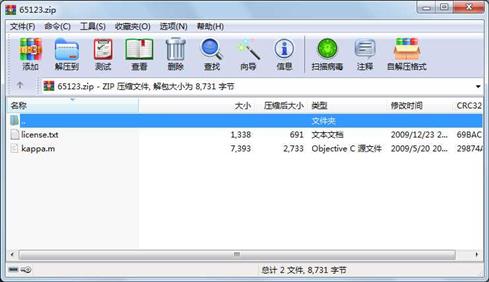

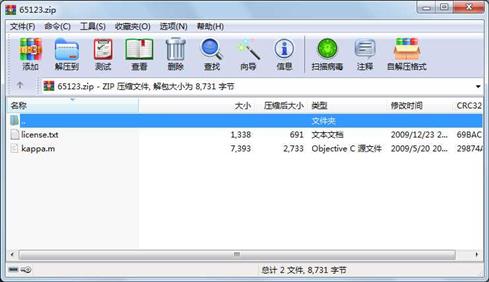

% Variance = 0.0031 z (k/sqrt(var)) = 8.8347 p属性 大小 日期 时间 名称

----------- --------- ---------- ----- ----

文件 7393 2009-05-20 12:38 kappa.m

文件 1338 2009-12-23 14:24 license.txt

- 上一篇:构造均值为a方差为b的高斯白噪声

- 下一篇:归一化8点算法-MATLAB代码

相关资源

- 高灵敏度GPS接收机MATLAB仿真,附捕获

- 基于MATLAB的质点弹道计算与外弹道优

- 阵列天线的matlab仿真

- MATLAB 经典程序源代码大全

- MATLAB小波软阈值去噪代码33473

- 天线阵的波束形成在MATLAB仿真程序及

- 非线性SVM算法-matlab实现

- 《MATLAB 智能算法超级学习手册》-程序

- 组合导航matlab程序

- 读取txt文件内容matlab代码实现

- Matlab实现基于相关的模板匹配程序

- matlab优化工具箱讲解

- 基于MATLAB的快速傅里叶变换

- 光纤传输中的分布傅立叶算法matlab实

- 基于matlab的图像处理源程序

- matlab 椭圆拟合程序

- 算术编码解码matlab源代码

- optical_flow 光流法 matlab 实现程序

- 引导图像滤波器 Matlab实现

- 分形几何中一些经典图形的Matlab画法

- OFDM系统MATLAB仿真代码

- SVM工具箱(matlab中运行)

- 图像小波变换MatLab源代码

- LU分解的MATLAB实现

- 冈萨雷斯数字图像处理matlab版(第三

- 替代数据法的matlab程序

- 用matlab实现的多站定位系统性能仿真

- 通过不同方法进行粗糙集属性约简m

- k近邻算法matlab实现

- matlab识别系统

川公网安备 51152502000135号

川公网安备 51152502000135号

评论

共有 条评论