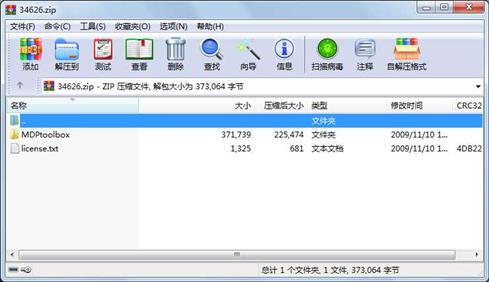

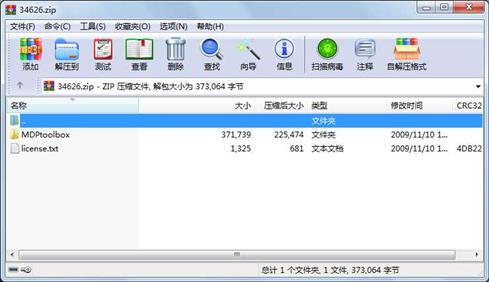

资源简介

2009年写的matlab mdp源码,里面有全部的英文document介绍说明

代码片段和文件信息

function [V policy] = mdp_bellman_operator(P PR discount Vprev)

% mdp_bellman_operator Applies the Bellman operator on the value function Vprev

% Returns a new value function and a Vprev-improving policy

% Arguments ---------------------------------------------------------------

% Let S = number of states A = number of actions

% P(SxSxA) = transition matrix

% P could be an array with 3 dimensions or

% a cell array (1xA) each cell containing a matrix (SxS) possibly sparse

% PR(SxA) = reward matrix

% PR could be an array with 2 dimensions or

% a sparse matrix

% discount = discount rate in ]0 1]

% Vprev(S) = value function

% Evaluation --------------------------------------------------------------

% V(S) = new value function

% policy(S) = Vprev-improving policy

% MDPtoolbox: Markov Decision Processes Toolbox

% Copyright (C) 2009 INRA

% Redistribution and use in source and binary forms with or without modification

% are permitted provided that the following conditions are met:

% * Redistributions of source code must retain the above copyright notice

% this list of conditions and the following disclaimer.

% * Redistributions in binary form must reproduce the above copyright notice

% this list of conditions and the following disclaimer in the documentation

% and/or other materials provided with the distribution.

% * Neither the name of the nor the names of its contributors

% may be used to endorse or promote products derived from this software

% without specific prior written permission.

% THIS SOFTWARE IS PROVIDED BY THE COPYRIGHT HOLDERS AND CONTRIBUTORS “AS IS“ AND

% ANY EXPRESS OR IMPLIED WARRANTIES INCLUDING BUT NOT LIMITED TO THE IMPLIED

% WARRANTIES OF MERCHANTABILITY AND FITNESS FOR A PARTICULAR PURPOSE ARE DISCLAIMED.

% IN NO EVENT SHALL THE COPYRIGHT HOLDER OR CONTRIBUTORS BE LIABLE FOR ANY DIRECT

% INDIRECT INCIDENTAL SPECIAL EXEMPLARY OR CONSEQUENTIAL DAMAGES (INCLUDING

% BUT NOT LIMITED TO PROCUREMENT OF SUBSTITUTE GOODS OR SERVICES; LOSS OF USE

% DATA OR PROFITS; OR BUSINESS INTERRUPTION) HOWEVER CAUSED AND ON ANY THEORY OF

% LIABILITY WHETHER IN CONTRACT STRICT LIABILITY OR TORT (INCLUDING NEGLIGENCE

% OR OTHERWISE) ARISING IN ANY WAY OUT OF THE USE OF THIS SOFTWARE EVEN IF ADVISED

% OF THE POSSIBILITY OF SUCH DAMAGE.

if discount <= 0 | discount > 1

disp(‘--------------------------------------------------------‘)

disp(‘MDP Toolbox ERROR: Discount rate must be in ]0; 1]‘)

disp(‘--------------------------------------------------------‘)

elseif ((iscell(P)) & (size(Vprev) ~= size(P{1}1)))

disp(‘--------------------------------------------------------‘)

disp(‘MDP Toolbox ERROR: Vprev must have the same dimension as P‘)

disp(‘--------------------------------------------------------‘)

elseif ((~iscell(P)) & (size(Vprev) ~= size(P1)))

属性 大小 日期 时间 名称

----------- --------- ---------- ----- ----

目录 0 2009-11-09 17:24 MDPtoolbox\

文件 63 2009-11-09 17:08 MDPtoolbox\AUTHORS

文件 1563 2009-11-09 17:08 MDPtoolbox\COPYING

文件 2437 2009-11-09 17:08 MDPtoolbox\README

目录 0 2009-11-09 17:08 MDPtoolbox\documentation\

文件 6876 2009-11-09 17:08 MDPtoolbox\documentation\BIA.png

文件 3110 2009-11-09 17:08 MDPtoolbox\documentation\DOCUMENTATION.html

文件 134450 2009-11-09 17:08 MDPtoolbox\documentation\INRA.png

文件 231 2009-11-09 17:08 MDPtoolbox\documentation\arrow.gif

文件 6469 2009-11-09 17:08 MDPtoolbox\documentation\index_alphabetic.html

文件 7022 2009-11-09 17:08 MDPtoolbox\documentation\index_category.html

文件 3245 2009-11-09 17:08 MDPtoolbox\documentation\mdp_LP.html

文件 4185 2009-11-09 17:08 MDPtoolbox\documentation\mdp_Q_learning.html

文件 3276 2009-11-09 17:08 MDPtoolbox\documentation\mdp_bellman_operator.html

文件 2959 2009-11-09 17:08 MDPtoolbox\documentation\mdp_check.html

文件 2465 2009-11-09 17:08 MDPtoolbox\documentation\mdp_check_square_stochastic.html

文件 2885 2009-11-09 17:08 MDPtoolbox\documentation\mdp_computePR.html

文件 3357 2009-11-09 17:08 MDPtoolbox\documentation\mdp_computePpolicyPRpolicy.html

文件 3363 2009-11-09 17:08 MDPtoolbox\documentation\mdp_eval_policy_TD_0.html

文件 7506 2009-11-09 17:08 MDPtoolbox\documentation\mdp_eval_policy_iterative.html

文件 2984 2009-11-09 17:08 MDPtoolbox\documentation\mdp_eval_policy_matrix.html

文件 3691 2009-11-09 17:08 MDPtoolbox\documentation\mdp_eval_policy_optimality.html

文件 6834 2009-11-09 17:08 MDPtoolbox\documentation\mdp_example_forest.html

文件 3833 2009-11-09 17:08 MDPtoolbox\documentation\mdp_example_rand.html

文件 4160 2009-11-09 17:08 MDPtoolbox\documentation\mdp_finite_horizon.html

文件 4940 2009-11-09 17:08 MDPtoolbox\documentation\mdp_policy_iteration.html

文件 4966 2009-11-09 17:08 MDPtoolbox\documentation\mdp_policy_iteration_modified.html

文件 7733 2009-11-09 17:08 MDPtoolbox\documentation\mdp_relative_value_iteration.html

文件 2082 2009-11-09 17:08 MDPtoolbox\documentation\mdp_span.html

文件 6731 2009-11-09 17:08 MDPtoolbox\documentation\mdp_value_iteration.html

文件 8689 2009-11-09 17:08 MDPtoolbox\documentation\mdp_value_iterationGS.html

............此处省略27个文件信息

- 上一篇:matlab实现newton迭代法

- 下一篇:用四元数法的捷联惯性导航姿态解算程序

相关资源

- MATLAB 经典程序源代码大全

- MATLAB小波软阈值去噪代码33473

- 天线阵的波束形成在MATLAB仿真程序及

- 非线性SVM算法-matlab实现

- 《MATLAB 智能算法超级学习手册》-程序

- 组合导航matlab程序

- 读取txt文件内容matlab代码实现

- Matlab实现基于相关的模板匹配程序

- matlab优化工具箱讲解

- 基于MATLAB的快速傅里叶变换

- 光纤传输中的分布傅立叶算法matlab实

- 基于matlab的图像处理源程序

- matlab 椭圆拟合程序

- 算术编码解码matlab源代码

- optical_flow 光流法 matlab 实现程序

- 引导图像滤波器 Matlab实现

- 分形几何中一些经典图形的Matlab画法

- OFDM系统MATLAB仿真代码

- SVM工具箱(matlab中运行)

- 图像小波变换MatLab源代码

- LU分解的MATLAB实现

- 冈萨雷斯数字图像处理matlab版(第三

- 替代数据法的matlab程序

- 用matlab实现的多站定位系统性能仿真

- 通过不同方法进行粗糙集属性约简m

- k近邻算法matlab实现

- matlab识别系统

- 神经网络分类matlab程序

- matlab正弦信号发生器的设计

- matlab程序用Hopfield网络解决TSP

川公网安备 51152502000135号

川公网安备 51152502000135号

评论

共有 条评论